WinlatorXR

881.97M · 2026-02-04

大家好,我是 Genyuan。

在日常后端开发中,Code Review(CR) 是保障代码质量的关键环节。但在高频迭代的现实下,CR 正在变成一件高消耗、易疲劳、且质量高度依赖个人状态的事情。

在实际工程实践中我越来越明确一件事:

比如:

因此,我们在团队中引入了一种方式:

先用 AI 做一轮前置 Code Review,再由人完成最终 Review。

这篇文章记录的是我在团队中,使用 Cursor 提升 Code Review 效率的一次工程化实践。

在双周甚至更快的迭代节奏下,人工 CR 普遍面临这些问题:

尤其是一些业务价值不高,但线上风险极大的问题(如空指针、越界、异常处理),非常适合交给 AI 处理。

不使用 AI 的情况下,CR 主要依赖:

这会带来几个明显问题:

整体效率和稳定性都有限。

在多种尝试之后,我选择使用 Cursor 来辅助 Code Review。

我的做法是:

把 Code Review 这件事,封装成一个“命令”,让 AI 按统一规则执行。

这套方案的核心是三点:

2.3.35 (Universal)Git MCP 配置示例:

{

"mcpServers": {

"git": {

"command": "uvx",

"args": ["mcp-server-git"]

}

}

}

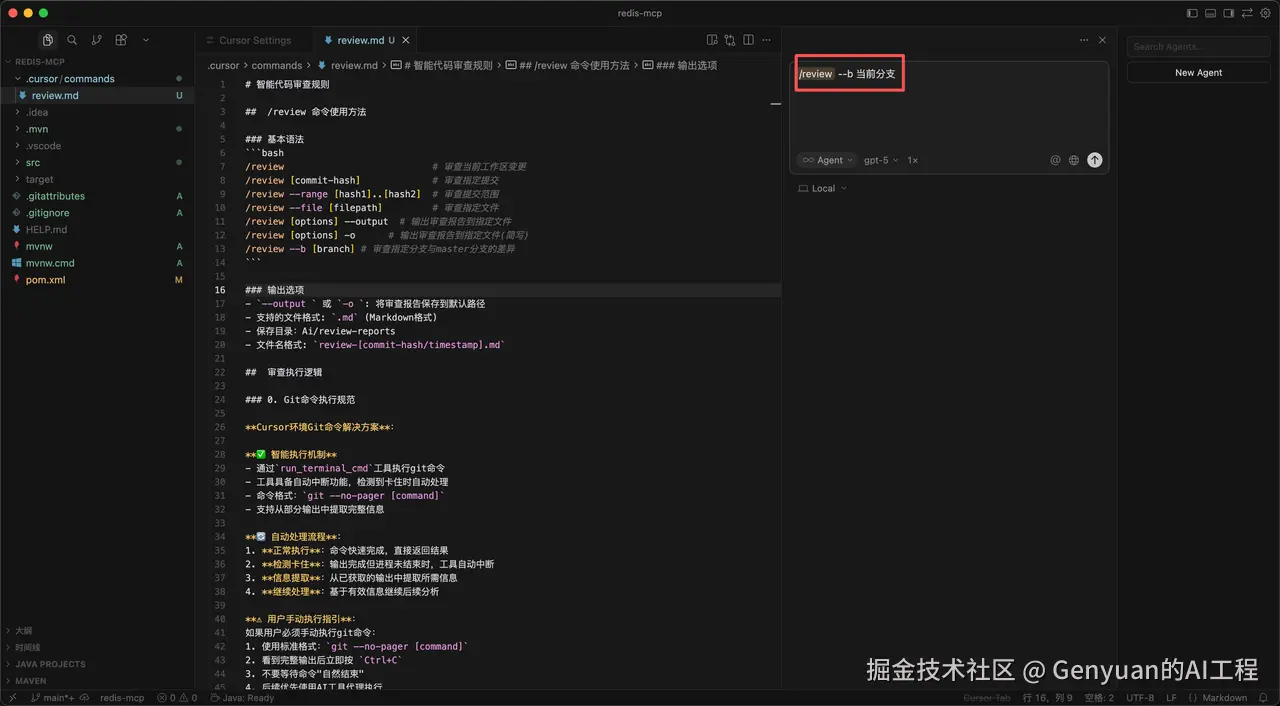

所有 CR 规则统一维护在 review.md 中:

github.com/ApolloNaco/…

核心思想只有一句话:

review.md 规则后,团队成员只需运行一个命令,即可让 Cursor 按规则执行 AI Code Review。

/review --b 当前分支

指定分支

--b 当前分支:对当前开发分支进行审查

可选参数:

-o:输出报告--file:审查指定文件AI 自动执行规则

review.md 中定义的规则生成结构化报告

开发者操作简化

问题:

Git 命令在 Cursor 中非常容易被分页器(pager)卡住,导致流程失败。

解决方式:

git --no-pagerrun_terminal_cmd 执行如果不处理这个问题,AI CR 基本不可用。

只审查以下文件:

.java.xml.properties目的只有一个:

聚焦真正影响逻辑和行为的代码,提高审查效率。

在 review.md 中的:

### 团队规范检查

这个模块下,由技术 Leader 维护必须被拦截的问题,例如:

原则很简单:

在规则中明确问题优先级:

这样可以让:

避免被细节淹没。

AI 最终输出结构化 Review 报告,包括:

可以直接同步到 PR 评论或 CI 流程中。

在真实项目中的效果非常直观:

组内反馈非常一致:

Leader 只需要维护两块内容:

本质上是把 Leader 的经验工程化。

review.md把问题拦在最早的阶段。

这不是功能堆砌,而是几条清晰的设计原则:

写成了命令风格,对开发友好。只需要按照提示敲命令即可。例如:/review --b -o [需要CR的分支]

用了Cursor AI的内置函数 run_terminal_cmd 提高执行效率

解决了cursor调git命令发生的常见问题:

git --no-pager [command] 处理代码时的分页问题git fetch --all --prune 避免了 CR的分支代码没有和最新的master分支对比的问题(多人开发尤其容易出现这个问题)设置了“团队规范检查”点,你可以在这个模块下写你们团队的常见团队规范,让AI在代码CR的时候帮你发现问题

设置严格的问题分级,可以聚焦重点问题的处理。

可以让AI最后分析的结果输出报告,集成到你们企业的CI/CD流程中。

让团队成员在每次写完代码之后,都先自己用AI CR一遍,把常见的团队问题和代码规范、低级错误自己先通过AICR的方式去避免。

目前这套 AI CR 仍有明显边界:

这些问题,我会在后续文章中展开

Genyuan