地壳免安装中文正式版

5.38G · 2025-10-29

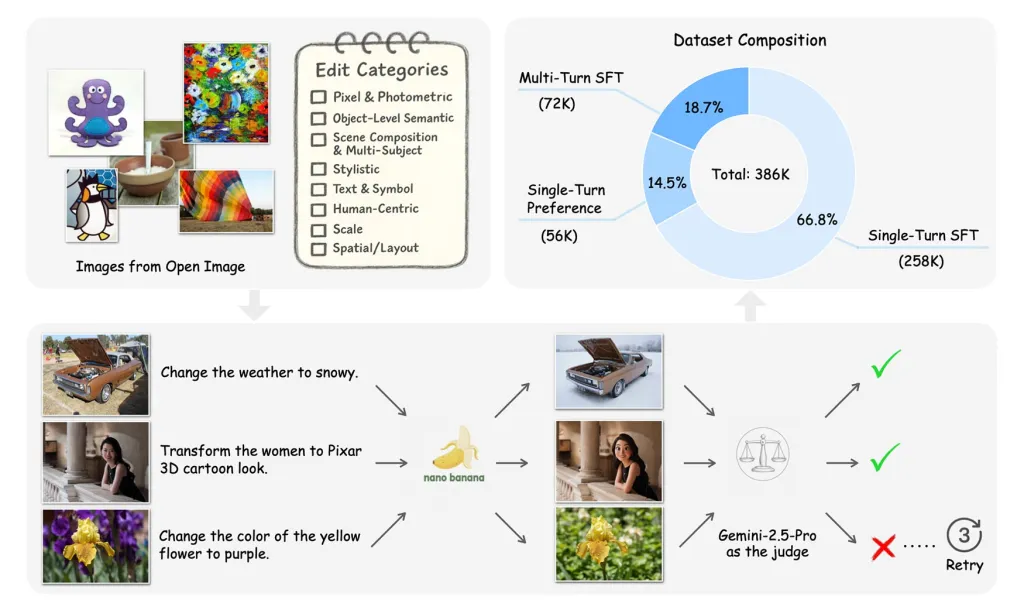

alixixi 10 月 29 日消息,苹果公司发布了 Pico-Banana-400K,这是一个包含 40 万张图像的研究数据集,有趣的是,该数据集是利用谷歌的 Gemini-2.5 模型构建的。

据alixixi了解,苹果的这个研究成果名为《Pico-Banana-400K:面向文本引导图像编辑的大规模数据集》(Pico-Banana-400K: A Large-Scale Dataset for Text-Guided Image Editing),该公司还发布了由此生成的包含 40 万张图像的完整数据集。该数据集采用非商业性研究许可(non-commercial research license)发布,意味着研究人员和学术机构可自由使用,但不得用于商业用途。

数月前,谷歌推出了 Gemini 2.5-Flash-Image 模型,也被称为 Nanon-Banana,该模型在图像编辑任务中表现出色,被广泛认为是当前最先进的图像编辑模型之一。尽管近年来多个模型在图像生成与编辑方面取得显著进展,苹果的研究团队指出:“尽管技术不断进步,开放研究仍受限于缺乏大规模、高质量且可完全共享的图像编辑数据集。现有数据集往往依赖专有模型生成的合成数据,或仅包含有限的人工筛选子集。此外,这些数据集普遍存在领域偏移(domain shifts)、编辑类型分布不均以及质量控制不一致等问题,严重阻碍了鲁棒图像编辑模型的发展。”

为解决这一瓶颈,苹果团队着手构建一个更全面、更具代表性的图像编辑数据集。

研究团队首先从 OpenImages 数据集中选取了大量真实照片,确保涵盖人物、物体及含文字场景等多样化内容。

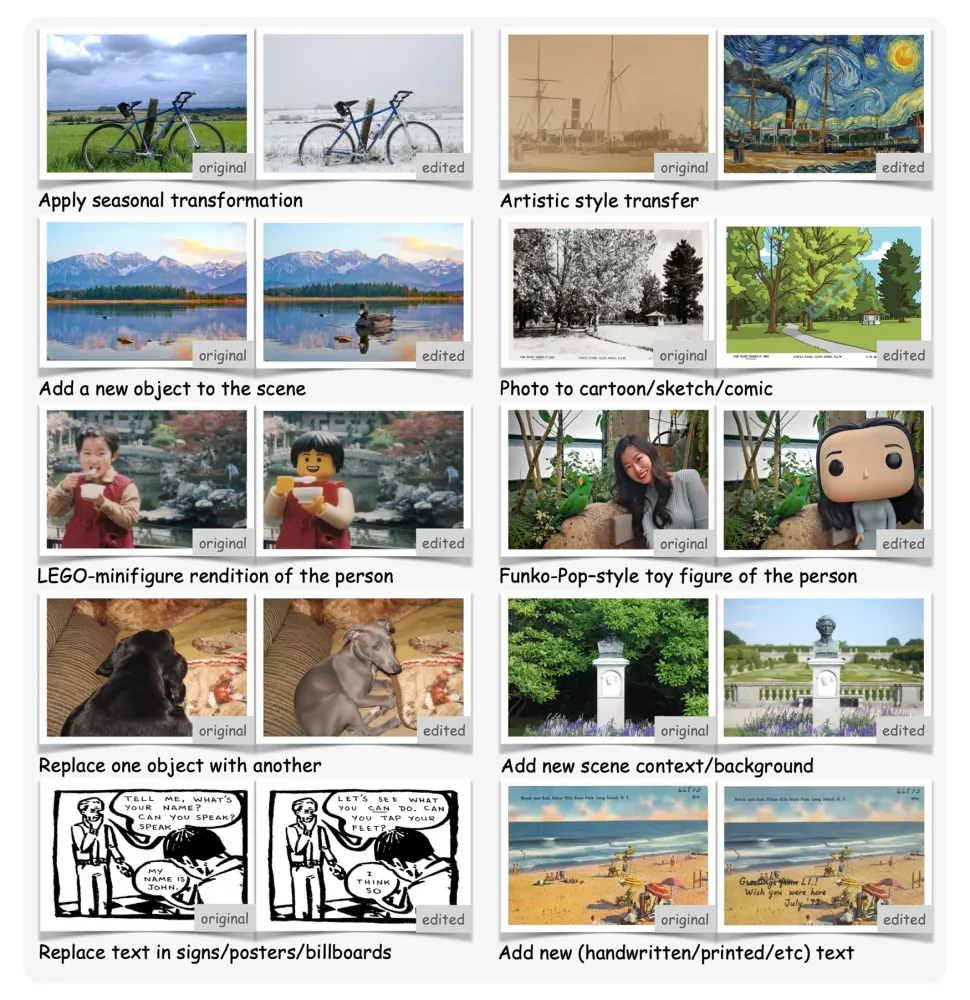

然后,团队设计了 35 种不同类型的图像修改指令,并将其归入八大类别,包括:

像素与光度调整(Pixel & Photometric):如添加胶片颗粒或复古滤镜;

以人为中心的编辑(Human-Centric):例如将人物转换为 Funko-Pop 风格的玩具形象;

场景构成与多主体编辑(Scene Composition & Multi-Subject):如改变天气条件(晴天 / 雨天 / 雪天);

对象级语义修改(Object-Level Semantic):如移动物体位置或调整空间关系;

图像缩放(Scale):如放大画面(Zoom in)等。

接下来,研究人员会将一张原始图像连同一条编辑指令输入至 Nanon-Banana 模型进行图像编辑。生成结果随后交由 Gemini 2.5-Pro 模型进行自动评估,判断其是否准确遵循指令并具备良好视觉质量。只有通过双重验证的结果才会被纳入最终数据集。

Pico-Banana-400K 不仅包含单轮编辑(single-turn edits,即一次提示完成编辑)的样本,还涵盖了多轮连续编辑序列(multi-turn edit sequences),以及“偏好对”(preference pairs)—— 即成功与失败编辑结果的对比样本,帮助模型学习区分理想与不良输出。

尽管研究团队承认 Nanon-Banana 在精细空间控制、布局外推和文字排版处理方面仍存在局限,但他们强调,Pico-Banana-400K 的目标是为下一代文本引导图像编辑模型提供一个坚实、可复现的训练与评测基础。

目前,相关研究论文已发布于预印本平台 arXiv,而完整的 Pico-Banana-400K 数据集也已在 GitHub 上向全球研究者免费开放。

5.38G · 2025-10-29

2.25G · 2025-10-29

61.6G · 2025-10-29